为何最近突然火了?没有颠覆性创新?关于ChatGPT/AIGC的核心问答

- 18

- 2023-02-07 21:40:13

- 900

为何最近突然火了?没有颠覆性创新?关于ChatGPT/AIGC的核心问答

来源:华尔街见闻 赵颖

申万宏源指出,ChatGPT优化负面结果,同时连贯对话也更加流畅,达到了可以商用的效果。但传统NLP最大缺陷,即自然语言理解、缺乏逻辑等问题,在GPT中仍未被解决。

近期,ChatGPT火爆全球,仅用了两个月就达到1亿活跃用户,成为史上用户增长最快的消费应用。

不仅如此,ChatGPT在资本市场掀投资狂潮,多只概念股持续走高,还吸引众多科技巨头争相入局。

同时,也有不少有关ChatGPT的问题,如为何最近突然火了?到底没有颠覆性创新?申万宏源证券洪依真团队在最新的报告中对这些关键问题一一作出解答。

Q1:为何GPT-3在2020年就推出了,而资本市场近期才开始对大模型高关注?

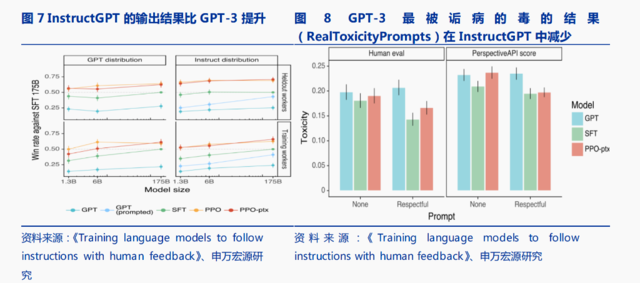

申万宏源指出,2020年的GPT-3仍有较多缺陷,其中无法商用的最大问题是输出结果有毒或不真实,OpenAI2022年1月正式公开了改良版InstructGPT。比GPT-3小了100多倍,仅有13亿个参数。

OpenAI使用了一种通过人类反馈来强化学习(RLHF)的现有技术,根据用户和API的交互结果,对模型的多个输出进行了排名,然后再利用这些数据微调GPT-3,大幅减少了有毒结果的输出。因此,我们现在看到的ChatGPT可以优化负面结果,同时连贯对话也更加流畅,达到了可以商用的效果。

Q2:为何也有人认为GPT等大模型并未对NLP做出颠覆式创新?

传统NLP最大缺陷,即自然语言理解、缺乏逻辑等问题,在GPT中仍未被解决。

GPT等模型依赖于大规模离线收集的语料进行训练,但是对于在线提供的即时信息,往往并不能进行充分理解并且纳入自己的回复中。更进一步的,对于对话中提供的因果关系,ChatGPT也往往缺乏很好的理解能力。

此外,GPT会给出部分问题貌似合理但不正确或荒谬的答案,或者过度使用一些词句和特定表达,同时缺乏类似人类的举一反三的能力等。

Q3:国内transformer大模型做的怎样?

申万宏源指出,首先需要承认这一类大模型底层创新在美国开始,2017年Google《AttentionIsAllYouNeed》首次提出了NLP模型Transformer,OpenAI的GPT-3等。中国在2021年后加速追赶,尤其是在CV大模型和多模态融合。

据国内OpenBMB开源社区统计,目前,在全球超千亿参数的大模型中,中国企业或机构贡献了1/3,美国贡献了1/2,世界其他国家或组织贡献了剩下的1/6。

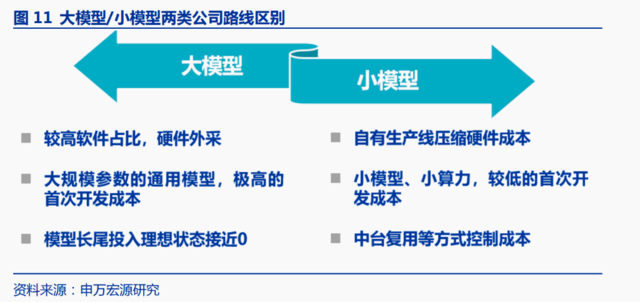

其次,国内大部分视觉类AI公司都以小模型路线为主,投入大模型研发较多的包括百度、华为等,优势可能会在多模态融合。

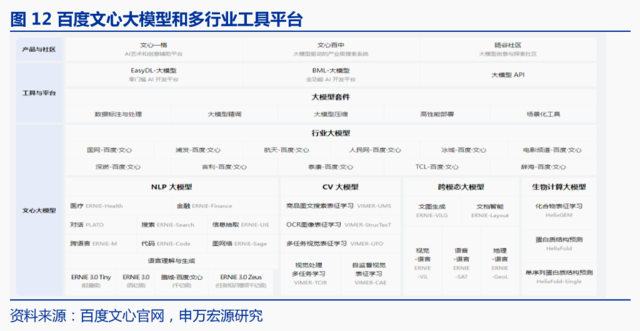

申万宏源在这里列剧了百度文心和华为盘古大模型:

百度文心大模型:NLP+CV,基本实现跨模态和多下游应用。应用场景涵盖:NLP大模型、CV大模型、跨模态大模型、生物计算大模型、行业大模型。API包括了:1)ERNIE3.0文本理解与创作:预置作文生成、文案创作、情感分析等任务提示,2)ERNIE-ViLGAI作画大模型,3)PLATO大模型开放域对话服务。

华为盘古大模型:最大中文语言预训练模型。2021年4月华为发布千亿参数40TB训练数据的全球最大中文语言(NLP)预训练模型,30亿参数的全球最大视觉(CV)预训练模型。将P-tuning、priming等最新技术融入到盘古的微调框架中,提升微调效果;在样本极少的情况下,盘古的少样本学习能力远超GPT系列和BERT系列;要得到相同的F1结果,盘古所需的数据量仅为中文 GPT-3的1/9,实现了近10倍的生产效率提升。

Q4:大规模预训练模型(大模型)与小模型的核心区别?大模型有什么优势?

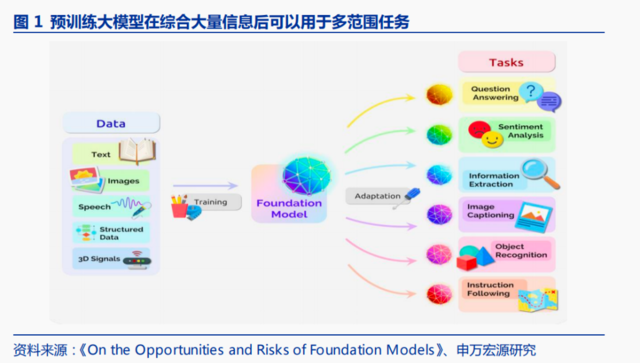

最核心区别在于参数量,例如GPT-3参数量达到了1,750亿个,是传统深度学习小模型参数量的至少一万倍以上。申万宏源表示,通过模型的扩大,可以带来提升包括:

1)GPT-2等大模型舍弃了小模型中常见的调参Fine-Tuning过程,转向容量更大、无监督训练。

2)在自然语言理解NLP中,常见任务包括翻译、问答、文本填空等,常见小模型需要对不同的任务使用不同模型分别训练解决,而GPT-3等大规模预训练模型不再规定任务,而是对以上不同任务都有较好效果。

3)传统的模型训练方式是反向传播算法,先对网络中的参数进行随机初始化,再利用随机梯度下降等优化算法不断优化模型参数,这种方式下对数据需求量较大。GPT-3先使用海量数据预训练大模型,得到一套模型参数,然后用这套参数对模型进行初始化,再进行训练。大幅降低后续对数据量的需求。

Q5:GPT-3等大模型和Transformer的关联?

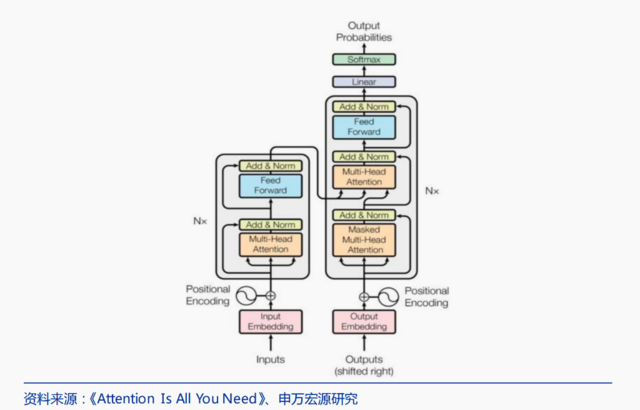

Transformer是目前NLP领域效果较好的深度学习模型,因此GPT/Bert等都使用了Transformer。

Transformer引入了Self-Attention自注意力机制:让机器注意到整个输入中不同部分之间的相关性。Transformer最大的特点是,可以让每个单元都可以捕捉到整句的信息,这也是RNN/LSTM等更早期NLP模型无法做到的一点。

Q6:大规模预训练思路对AI应用落地有什么帮助?

小模型时代,商用模型开发会综合考虑调参等研发投入量和带来的商业价值,模型开发出来后能否复用以摊薄研发成本,同时对于部分训练样本量较少的场景,没有很好解决方法。

大模型可以在长尾场景应用落地,降低训练成本、减少数据要求。基于大规模预训练思路,一方面大模型可以应对多个泛化任务,大模型+细分场景微调,更适合长尾落地;另一方面,对于小样本训练,大模型也有较好提升。

Q7:那Transformer对于CV机器视觉可以有类似NLP的提升吗?

Transformers用在CV上的难点,Transformers自注意力操作中,每个元素需要和每个元素互相进行两两互动,最后算得一个Attention自注意力图,通过加权平均,最后得到输出。由于单元间两两互动,因此复杂度是序列长度的平方,也就是n^2,在自然语言处理中,一个句子的长度一般就是几百或上千,例如BERT为512序列长度。

而对于一个比较常见的224x224大小的图片,如果直接以每一个像素点为单位进行两两互动的话,那序列长度为50176,大概为BERT序列长度的100倍,因此复杂度极高。

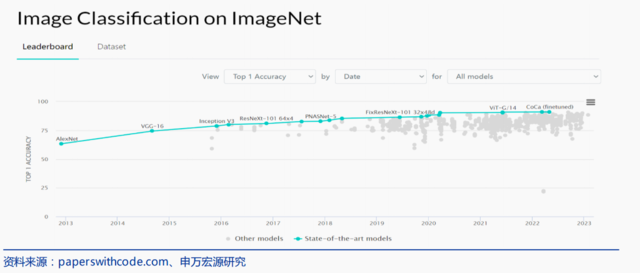

但在2021年后,随着swintransformer、mae等论文推出,transformer在CV和跨模态等应用增加。因此,国内擅长CV的AI公司,在2022年前对于基于transformer的大模型关注投入较少,但是申万宏源认为随着VIT等效果提升,应用类的CV公司也会开始关注并投入大模型。

Q8:怎样的公司有机会参与大模型底层技术研发?

申万宏源认为大模型对存储、算力要求极高,普通机构或难以复现。GPT-3发布一年后,只有NVIDIA、微软等大企业可以复现。

据NVIDIA估算,如果要训练GPT-3,即使单个机器的显存/内存能装得下,用8张V100的显卡,训练时长预计要36年;如果拥有1024张80GBA100,那么完整训练GPT-3的时长可以缩减到1个月。

以微软与OpenAI合作建造的AzureA工智能算力平台为例,该算力平台投资约10亿美元,使用该超算中心训练一次超大模型GPT-3大约花费1200万美元。同时需要解决分布式训练问题:上百台服务器之间的通信、拓扑、模型并行、流水并行等问题,模型训练是显存峰值问题。

本文主要摘取自申万宏源报告《ChatGPT/AIGC 九问九答》

风险提示及免责条款

市场有风险,投资需谨慎。本文不构成个人投资建议,也未考虑到个别用户特殊的投资目标、财务状况或需要。用户应考虑本文中的任何意见、观点或结论是否符合其特定状况。据此投资,责任自负。

发表评论